含一篇Spotlight,涵蓋ML、CV、NLP等方向,以及AI在遊戲、科研等領域的融合探索。

NeurIPS 2023(Neural Information Processing Systems)神經信息處理系統大會是當前全球最負盛名的AI學術會議之一,將於12月10日在美國新奧爾良召開。根據官網郵件顯示,本屆會議共有12343篇有效論文投稿,接收率爲 26.1%,高於 2022 年的 25.6%。

今年騰訊 AI Lab 共有18篇論文入選,包含一篇 Spotlight,內容涵蓋機器學習、計算機視覺、自然語言處理等方向,以及AI在科研、遊戲等領域的融合探索。

以下爲論文概覽。

機器學習

1. GADBench:重新審視和基準監督圖異常檢測

GADBench:重新審視和基準測試監督圖異常檢測

論文鏈接:

https://arxiv.org/abs/2306.12251

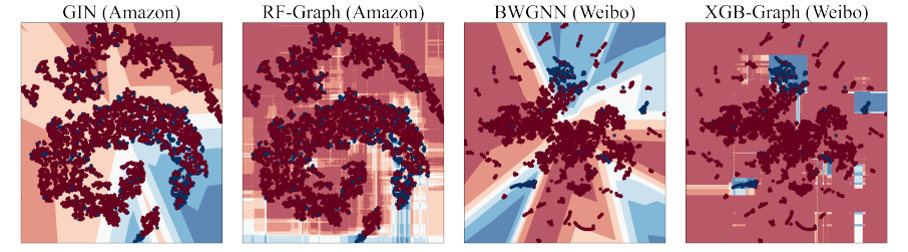

本文由AI Lab主導,和香港科技大學(廣州)合作完成。傳統的圖異常檢測(GAD)算法和最近流行的圖神經網絡(GNN)有着悠久的歷史,但目前尚存在三個問題:1)它們在標準綜合設置下的性能如何;2)GNN是否優於傳統的算法,如樹集成;3)它們在大規模圖上的效率如何。

基於此,本文引入了GADBench——一個專門用於靜態圖中監督異常節點檢測的基準工具。GADBench有助於在10個真實世界的GAD數據集上進行29種不同模型的詳細比較,包括數千到數百萬(~ 6M)個節點。本文的主要發現是,具有簡單鄰域聚合的樹集成可以優於爲GAD任務量身定製的最新GNN。本文闡明瞭 GAD 當前的進展,並系統地評估了圖異常檢測算法,爲後續圖異常檢測研究提供了系統的基準測試標準。

不同方法的決策邊界比較。 藍點代表異常節點,紅點代表正常節點。 同樣,藍色/紅色區域對應於異常/正常類的模型預測

2. 通過環境增強學習不變性圖能學習不變性嗎?

圖不變學習真的學到了不變性嗎?

論文鏈接:https://openreview.net/forum?id=EqpR9Vtt13

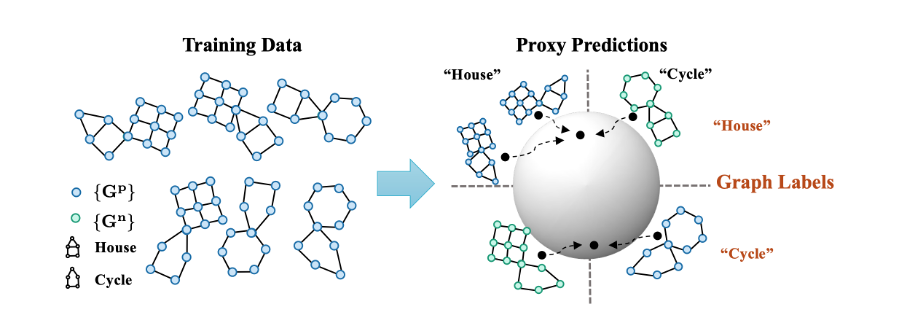

本文由騰訊AI Lab主導,與香港中文大學和香港浸會大學合作完成。不變圖表示學習旨在學習來自不同環境/域的圖數據之間的不變性,以便於圖上的分佈外泛化。由於圖環境劃分通常難以獲得,因此現有的方法大多通過增強環境信息來彌補這一缺陷。然而,現有各類算法增強得到的環境信息的有效性從未得到驗證。

在這項工作中,作者團隊發現通過環境增強來學習不變圖表示,在沒有額外假設的情況下根本是不可能的。爲此,本文開發了一套最小假設,包括變化充分性和變化一致性。然後,本文提出了一個新框架——圖不變學習助手(GALA)。GALA包含一個需要對圖環境變化或分佈變化敏感的助手模型,助手模型的代理預測的正確性因此可以區分雜散子圖中的變化。

通過提取對代理預測最大限度不變的子圖,該方法可以在建立的最小假設下證明地識別出成功的分佈外泛化所需的基礎不變子圖。在包括DrugOOD在內的各種圖分佈變化的數據集上進行的廣泛實驗證實了GALA的有效性,可以解決AI輔助製藥中的分佈變化問題。

3. 理解和改進分佈外泛化的特徵學習

理解並提升分佈外泛化中的特徵學習

論文鏈接:https://openreview.net/forum?id=eozEoAtjG8

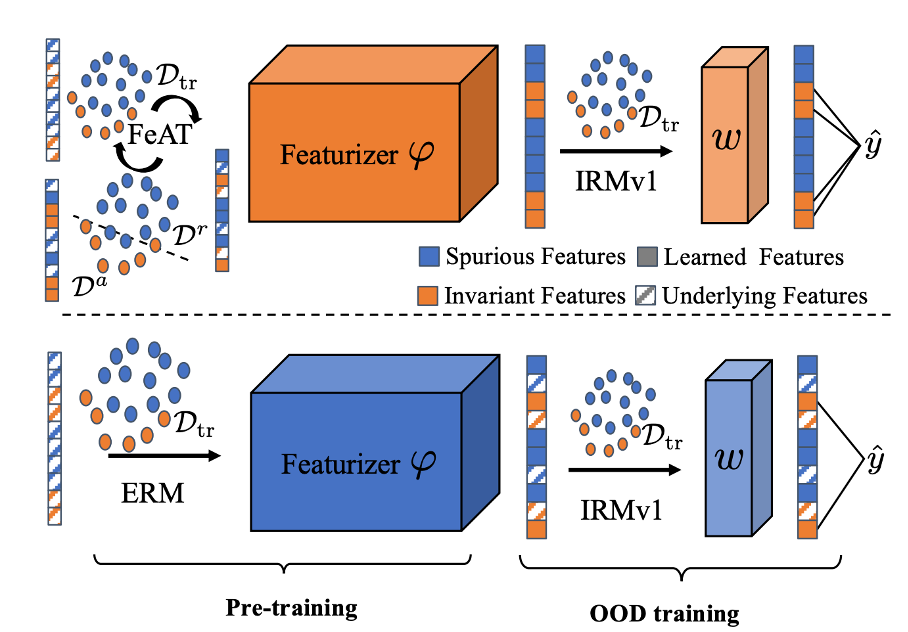

本文由騰訊AI Lab主導,與香港中文大學、RIKEN AIP、香港浸會大學合作完成。對於分佈外(OOD)泛化失敗的常見解釋是,採用經驗風險最小化(ERM)訓練的模型學習了虛假特徵而不是不變特徵。然而,最近的幾項研究對這一解釋提出了挑戰,並發現深度網絡可能已經學習了足夠好的特徵以進行OOD泛化。

儘管乍一看似乎存在矛盾,但本文理論上展示了ERM本質上學習了虛假特徵和不變特徵,而如果虛假相關性更強,ERM傾向於更快學習虛假特徵。此外,當使用ERM學習的特徵進一步進行使用OOD目標進行訓練時,不變特徵學習的質量顯著影響最終的OOD性能,因爲OOD目標很少學習新特徵。因此,ERM特徵學習可能成爲OOD泛化的瓶頸。

爲了減輕這種依賴,本文提出了特徵增強訓練(FeAT),以促使模型學習更豐富的特徵,爲OOD泛化做好準備。FeAT迭代地增強模型以學習新特徵,同時保留已經學習的特徵。在每一輪中,保留和增強操作在捕獲不同特徵的訓練數據的不同子集上進行。廣泛的實驗證明,FeAT有效地學習了更豐富的特徵,從而提高了各種OOD目標的性能。

4. 從有害數據中保留有益信息用於神經網絡修復

基於有益信息提純的模型修復算法

論文鏈接:

https://openreview.net/pdf?id=BJ1vOqh3hJ

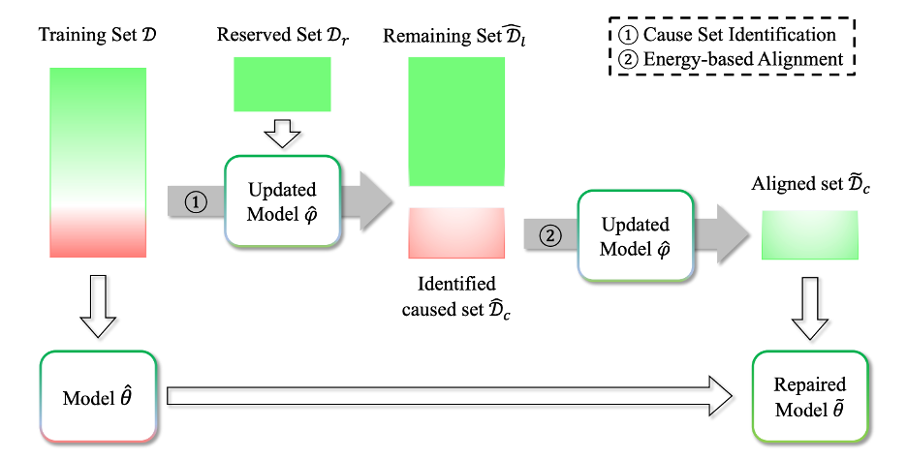

本文由騰訊AI Lab 主導,與香港中文大學合作完成。深度學習模型的表現很大程度上取決於訓練數據的質量。訓練數據的不足之處,如損壞的輸入或帶有噪聲的標籤,可能導致模型泛化能力不佳。近期的研究提出,通過找出導致模型失效的訓練樣本並消除它們對模型的影響,可以修復模型。然而,被識別出的數據可能同時包含有益和有害信息。簡單地從模型中刪除被識別數據的信息可能會對其性能產生負面影響,尤其是當正確的數據被誤認爲是有害的並被移除時。

爲了應對這一挑戰,本文提出了一種新穎的方法,利用保留下來的乾淨數據集中的知識。該方法首先利用乾淨數據集來識別有害數據,然後在被識別的數據中區分有益和有害信息。最後,本文利用提取出的有益信息來提升模型的性能。通過實證評估,該方法在識別有害數據和修復模型失效方面優於基準方法;特別是在識別困難且涉及大量良性數據的場景中,該方法在保留有益信息的同時提高了性能,而基準方法由於錯誤地刪除有益信息而性能下降。

5. 基於能量模型的安全分佈外任務泛化

基於能量模型的元學習算法

論文鏈接

: https://openreview.net/pdf?id=tt7bQnTdRm

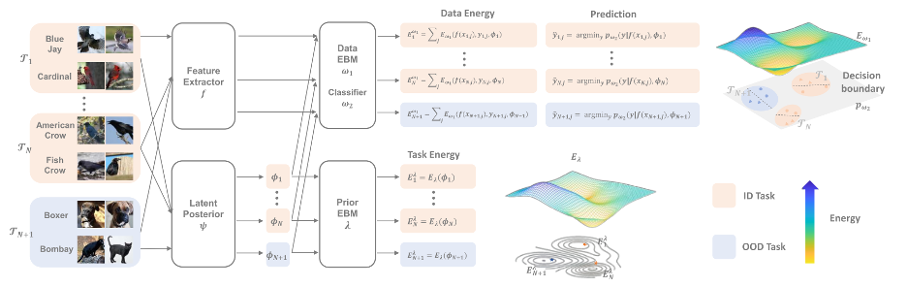

本文由騰訊AI Lab與香港城市大學,麻省理工大學合作完成。元學習在處理現實中的分佈外(OOD)任務時,其成功率並不穩定。爲了確保元學習中獲得的先驗知識能夠有效地應用到 OOD 任務上,特別是在注重安全的應用時,往往需要先檢測出 OOD 任務,然後再將這些任務調整以適應先驗知識。然而,現有的貝葉斯元學習方法在評估 OOD 任務的不確定性時,由於特徵分佈偏移的覆蓋不全和元學習先驗的表達能力不足,其可靠性受到了限制。此外,這些方法在調整 OOD 任務時也面臨困難,這與跨領域任務調整解決方案的情況相似,後者容易出現過擬合的問題。

因此,本文構建了一個統一的框架,既可以檢測和調整 OOD 任務,又可以與現有的元學習框架兼容。本文提出的基於能量的元學習(EBML)框架,通過兩個表達能力強的神經網絡能量函數的組合,學習描述任意元訓練任務分佈。本文將這兩個能量函數的和作爲檢測 OOD 任務的可靠評分;在元測試階段,通過最小化能量來將 OOD 任務調整爲分佈內的任務。在四個迴歸和分類數據集上進行的實驗證明了該方法的有效性。

6. 大圖表示的簡化和授權變壓器

用於大圖表示學習的簡化且強大的 Transformer 架構

論文鏈接

: https://openreview.net/forum?id=R4xpvDTWkV

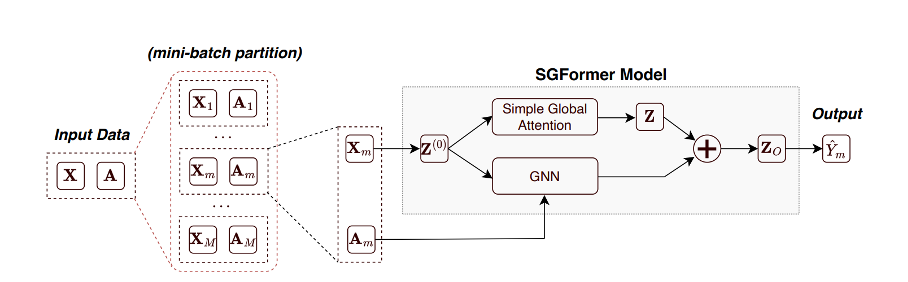

本文由騰訊AI Lab與上海交通大學,伊利諾伊大學厄巴納-香檳分校和紐約大學合作完成。由於海量數據點之間存在相互依賴的性質,學習大型圖上的表示是一個長期存在的挑戰。Transformer 作爲一類新興的圖結構數據基礎編碼器,由於其全局注意力能夠捕獲相鄰節點之外的所有對影響,因此在小圖上表現出了良好的性能。即便如此,現有的方法傾向於繼承 Transformer 在語言和視覺任務中的特點,並通過堆疊深度多頭注意力來擁抱複雜的模型。

本文批判性地證明,即使使用單層注意力也可以在節點屬性預測基準上帶來令人驚訝的性能,其中節點數量範圍從千級到十億級。這激發作者重新思考大圖上 Transformer 的設計理念,其中全局注意力是阻礙可擴展性的計算開銷。本文將所提出的方案設計爲Simplified Graph Transformers(SGFormer),它由一個簡單的注意力模型支持,可以在一層中的任意節點之間有效地傳播信息。SGFormer 不需要位置編碼、特徵/圖預處理或增強損失。根據實驗,SGFormer 成功擴展到網絡規模圖 ogbn-papers100M,並在中型圖上比 SOTA Transformer 產生高達 141 倍的推理加速。除了當前的結果之外,本文所提出的方法本身預計將啓發在大圖上構建 Transformer 的獨立興趣的新技術路徑。

7. 圖數據上的噪聲僞標記的深入研究

深入理解圖形數據中噪聲僞標籤

論文鏈接

: https://openreview.net/pdf?id=XhNlBvb4XV

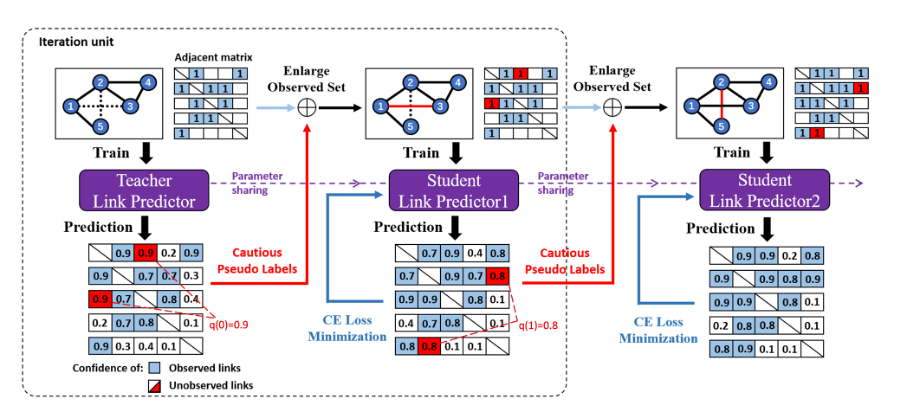

本文由騰訊AI Lab與香港科學大學(廣州)合作完成。僞標籤(PL)是一種廣泛應用的訓練策略,通過在訓練過程中對潛在樣本進行自我標註,從而擴大標記數據集。許多研究表明,這種方法通常可以提高圖學習模型的性能。然而,本文作者注意到錯誤的標籤可能對圖訓練過程產生嚴重影響。不恰當的 PL 可能導致性能下降,尤其是在噪聲可以傳播的圖數據上。令人驚訝的是,文獻中很少對相應的錯誤進行理論分析。

本文旨在深入探討 PL 在圖學習模型中的作用。首先,本文通過展示 PL 閾值的置信度和多視圖預測的一致性來分析 PL 策略的誤差。接着,本文從理論上闡述了 PL 對收斂性質的影響。基於這些分析,本文提出了一種謹慎的僞標籤方法,且爲具有最高置信度和多視圖一致性的樣本添加僞標籤。最後,大量實驗表明,本文所提出的策略改進了圖學習過程,並在鏈接預測和節點分類任務上優於其他 PL 策略。

計算機視覺

8. 通過名人基礎在擴散模型中插入任何人

在擴散模型中插入任何人

論文鏈接

: https://openreview.net/pdf?id=OGQWZ3p0Zn

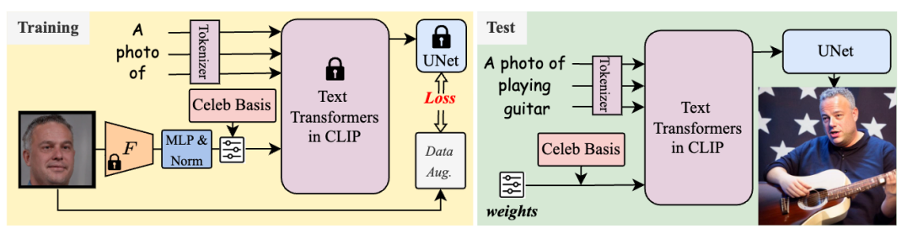

本文由騰訊AI Lab主導,與中山大學、香港科技大學合作完成。精美的需求存在於定製預訓練的大型文本到圖像模型,以生成創新概念,如用戶自身。然而,在訓練期間給定幾張圖像後,與原始概念相比,先前定製方法中新增加的概念往往顯示出較弱的組合能力。

因此,本文提出了一種新的個性化方法,允許使用一個面部段落和僅1024個參數在3分鐘內無縫集成獨特個體到預訓練的擴散模型中。該方法可以毫不費力地從文本提示中生成這個人在任何姿勢或位置、與任何人互動和做任何可想象的事情的驚人圖像。爲實現這一目標,本文首先分析並從預訓練的大型文本編碼器的嵌入空間中構建一個明確的名人基礎。然後,給定一張面部照片作爲目標身份,通過優化該基礎的權重並鎖定所有其他參數來生成其自身的嵌入。在該定製模型中,由所提議的名人基礎賦予的新身份展示出比以前的個性化方法更好的概念組合能力。此外,該模型還可以一次學習多個新身份並相互交互,而以前的定製模型無法實現這一點。

9. DeepfakeBench:深度僞造檢測的綜合基準

DeepfakeBench:深度僞造檢測的全面基準測試

論文鏈接

: https://openreview.net/forum?id=hizSx8pf0U

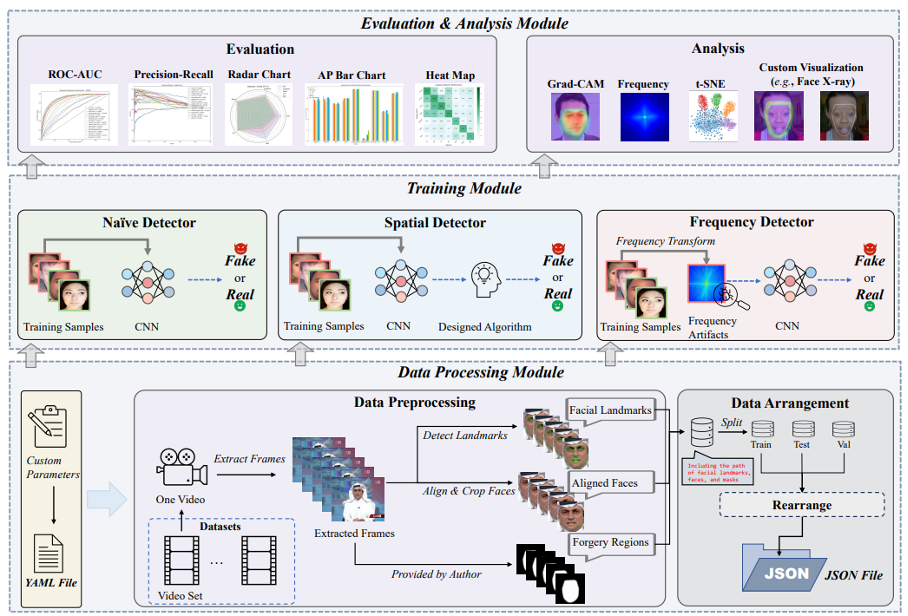

本文由騰訊AI Lab主導,與香港中文大學(深圳)、美國紐約州立大學布法羅分校合作完成。 在深度僞造檢測(Deepfake)領域,一個關鍵但經常被忽視的挑戰是缺乏一個標準化、統一、全面的基準。這個問題導致了不公平的性能比較和可能產生誤導的結果。具體來說,數據處理流程缺乏一致性,導致檢測模型的數據輸入不一致。此外,實驗設置存在明顯差異,評估策略和指標缺乏標準化。

爲了填補這一空白,本文提出了第一個全面的深度僞造檢測基準,稱爲DeepfakeBench,它提供了三個關鍵貢獻:1)一個統一的數據管理系統,以確保所有檢測器的輸入一致;2)一個集成的最先進方法實現框架;3)標準化的評估指標和協議,以促進透明度和可重複性。DeepfakeBench具有可擴展、基於模塊的代碼庫,包含15種最先進的檢測方法、9個深度僞造數據集、一系列深度僞造檢測評估協議和分析工具,以及全面的評估。此外,本文還從各種角度(如數據增強、主幹網絡)對這些評估進行了廣泛分析,提供了新的見解,以期在該關鍵的領域推動創新。

基準測試代碼、評估和分析已開源:https://github.com/SCLBD/DeepfakeBench。

10 .GPT4Tools:通過自我指導教大型語言模型使用工具

GPT4Tools: 基於自指引教授大語言模型使用工具

論文鏈接

: https://openreview.net/pdf?id=cwjh8lqmOL

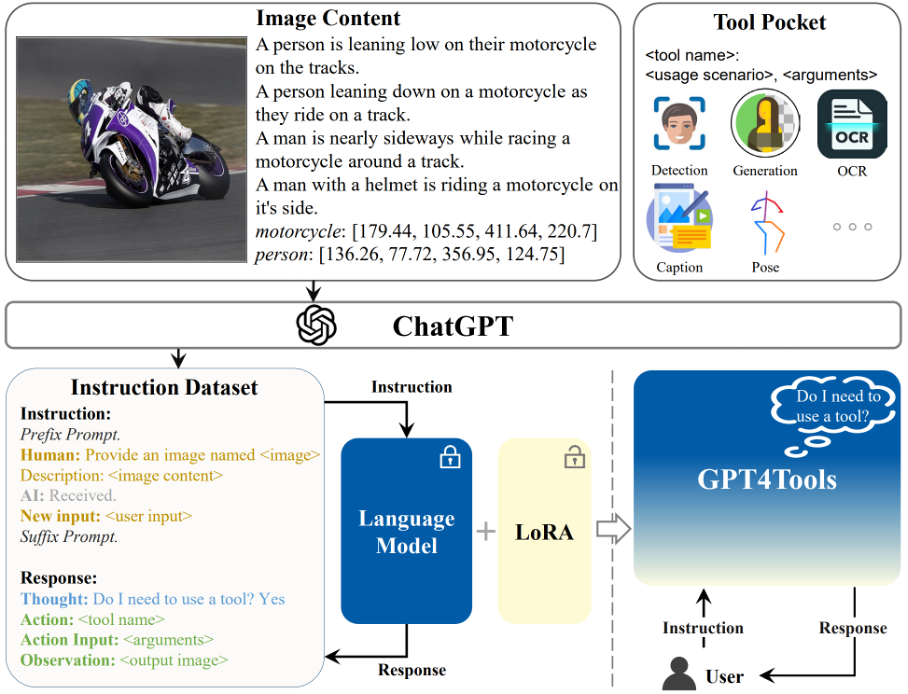

本文由騰訊AI Lab主導,與清華大學深圳研究生院、香港中文大學合作完成。這篇論文的目的是爲了高效地使大型語言模型(LLMs)能夠使用多模態工具。像ChatGPT和GPT-4這樣的高級專有LLMs已經通過複雜的提示工程顯示出了使用工具的巨大潛力。然而,這些模型通常依賴於高昂的計算成本和公衆無法獲取的數據。

爲了解決這些挑戰,本文提出了基於自我指導的GPT4Tools,使開源LLMs(如LLaMA和OPT)能夠使用工具。該方法通過向一位高級教師提示多種多模態情境,生成了一個指令跟隨數據集。通過使用低秩適應(LoRA)優化,該方法幫助開源LLMs解決一系列視覺問題,包括視覺理解和圖像生成。此外,本文提供了一個基準測試來評估LLMs使用工具的能力,這種測試既包括零次射擊方式,也包括微調方式。廣泛的實驗表明,該方法對各種語言模型都有效,不僅顯著提高了調用已見工具的準確性,還實現了對未見工具的零次射擊能力。

代碼和演示鏈接:https://github.com/AILab-CVC/GPT4Tools

11.元適配器:一種用於視覺語言模型的在線少鏡頭學習器

Meta-Adapter: 面向視覺語言模型的在線小樣本學習網路

論文鏈接

: https://openreview.net/pdf?id=Ts0d8PvTeB

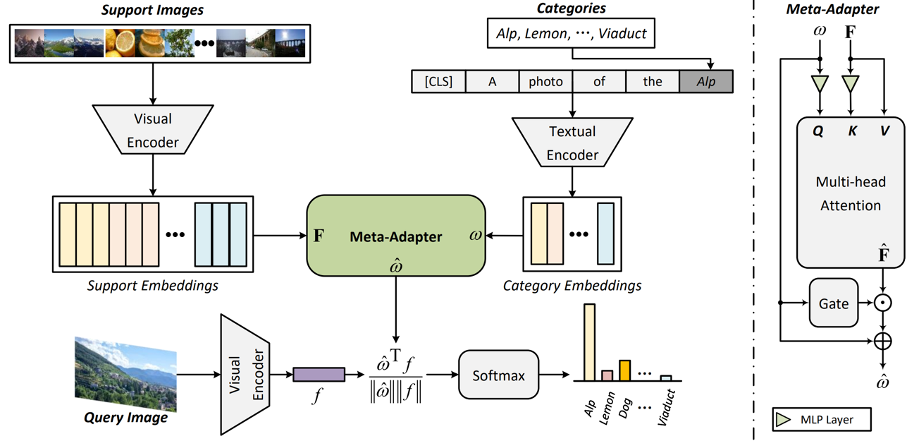

本文由騰訊AI Lab主導,與西安交通大學合作完成。本文介紹的對比式視覺語言預訓練,即CLIP,顯示出在理解開放世界視覺概念方面的顯著潛力,使得零樣本圖像識別成爲可能。然而,基於CLIP的少樣本學習方法通常需要在少量樣本上離線微調參數,這導致推理時間延長和在某些領域過擬合的風險。

爲了應對這些挑戰,本文提出了一種輕量級的殘差式適配器——Meta-Adapter,通過少量樣本在線方式指導優化CLIP特徵。只需少量訓練樣本,該方法就能有效開啓少樣本學習能力,並在未見數據或任務上實現無需額外微調的泛化,取得了具有競爭力的性能和高效率。該方法無需額外複雜操作,在八個圖像分類數據集上平均超過最新的在線少樣本學習方法3.6%,且具有更高的推理速度。此外,該模型簡單靈活,可作爲直接適用於下游任務的即插即用模塊。在無需進一步微調的情況下,Meta-Adapter在開放詞彙目標檢測和分割任務中取得了顯著的性能提升。

自然語言處理

12.大型語言模型的公平引導少鏡頭提示

公平引導的大語言模型上下文提示方法

論文鏈接:

https://arxiv.org/abs/2303.13217

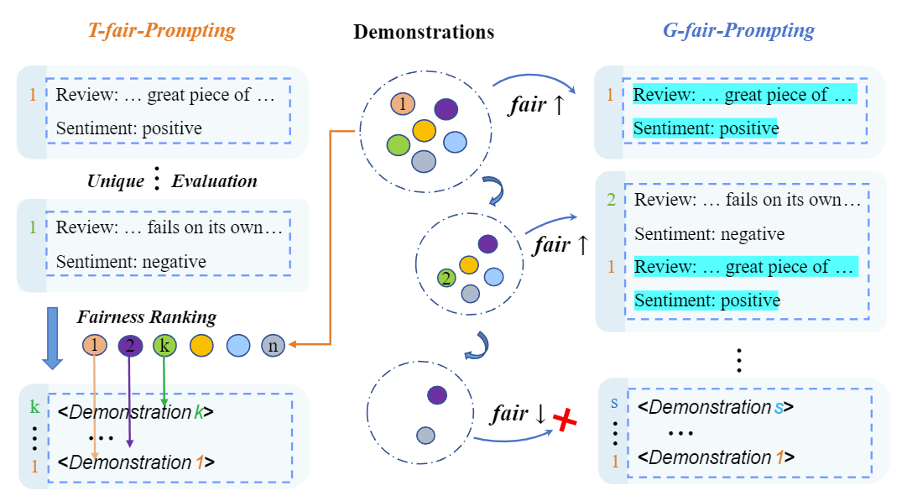

本文由騰訊AI Lab主導,與天津大學,新加坡科技研究局(A*STAR)合作完成。大型語言模型展示了驚人的能力,可以進行上下文學習,即這些模型可以通過依據少量輸入-輸出示例構建的提示來直接應用於解決衆多下游任務。然而,先前的研究表明,由於訓練示例、示例順序和提示格式的變化,上下文學習可能會遭受高度不穩定的問題。因此,構建適當的提示對於提高上下文學習的性能至關重要。

本文從預測偏差的角度重新審視這個問題。具體而言,本文引入了一個度量標準來評估固定提示相對於標籤或給定屬性的預測偏差。通過實驗證明,具有更高偏差的提示總是導致不令人滿意的預測質量。基於這一觀察,本文提出了一種基於貪婪搜索的新型搜索策略,用於識別接近最優的提示,以提高上下文學習的性能。通過對包括GPT-3在內的最先進的主流模型進行了全面實驗(涉及各種下游任務),結果表明,該方法可以以一種有效且可解釋的方式增強模型的上下文學習性能,使大語言模型的表現更加可靠。

13. 重複輸入重複輸出:從數據的角度理解神經文本退化

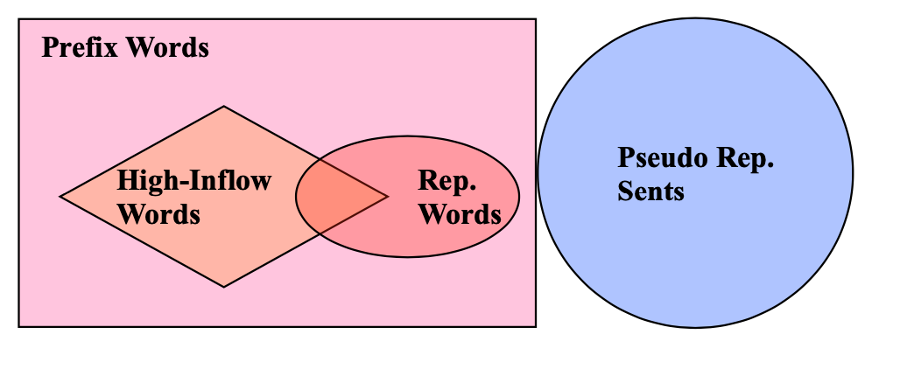

Repetition In Repetition Out: 從數據角度理解神經網絡文本生成中的退化問題

論文鏈接:https://openreview.net/pdf?id=WjgCRrOgip

本文由騰訊AI Lab與奈良先端科學技術大學院大學、劍橋大學、Cohere合作完成。關於神經網絡文本生成中的退化問題(即語言模型傾向於生成重複和陷入循環)存在許多不同的假設,使得這個問題既有趣又令人困惑。本文從數據的角度理解這個問題,並提供了一個簡單而基本的解釋。研究顯示,退化問題與訓練數據中的重複的相關性很強。實驗表明,通過在訓練數據中有選擇地減少對重複的關注,可以顯著減少退化。此外,以往從不同立場(如高流入詞、最大似然目標和自我強化)出發的假設可以用本文提出的簡單解釋來統一。也就是說,懲罰訓練數據中的重複是它們有效性的共同基礎。實驗表明,即使在更大的模型尺寸和指令微調後,懲罰訓練數據中的重複仍然至關重要。

遊戲AI

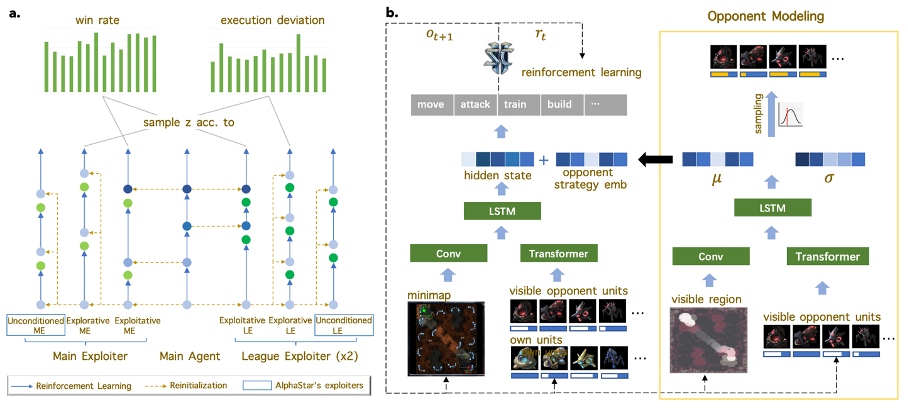

14.《星際爭霸2》中穩健且具有對手意識的聯盟訓練方法

一種魯棒且具有對手認知的星際爭霸2聯盟訓練方法

論文鏈接:https://openreview.net/pdf?id=tDAu3FPJn9

本文由騰訊AI Lab獨立完成,已被會議接收爲Spotlight。在星際爭霸2(星際2)這種大型RTS遊戲中訓練一個超乎常人水平的AI是極其困難的。受博弈論方法啓發,AlphaStar提出了一種聯盟訓練框架(league training framework),成爲首個在星際2中擊敗人類職業玩家的AI。

本文從兩個重要的方面對AlphaStar的聯盟訓練進行改進。該項工作使用了目標趨向的利用者(goal-conditioned exploiters)來增強AlphaStar中的無目標的利用者(unconditioned exploiters),大大提升了利用者發現主代理(main agent)和整個聯盟弱點的能力;此外,爲聯盟中的代理增加了對手建模能力,使代理能更加迅速地響應對手的實時策略。基於這些改進,作者團隊用比AlphaStar更少的資源訓練出了一個更魯棒的超越人類玩家水平的AI,與多位頂級職業玩家分別進行的20局比賽中均保持了50%以上的勝率。該研究爲大型複雜的兩人零和非完美信息博弈場景求解魯棒策略提供了有價值的參考。

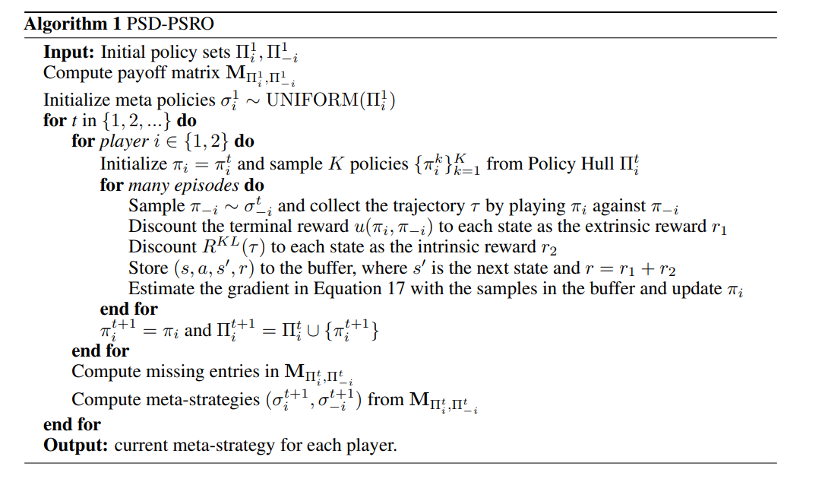

15.非傳遞博弈的策略空間多樣性

非傳遞性博弈遊戲中的策略空間多樣性

論文鏈接:https://arxiv.org/pdf/2306.16884.pdf

本文由騰訊AI Lab獨立完成。在多智能體非傳遞博弈中,PSRO是一個影響力強大的算法框架,能夠較高效地尋找博弈中的納什均衡策略。許多先前的研究試圖在PSRO中提升策略多樣性,然而,大多數此類工作的一個主要不足是,一個更多樣(按照他們的定義)的策略集合並不一定意味着(如本文中證明的)更高的強度。

爲了解決這個問題,本文從策略空間上定義一個新的多樣性指標,在訓練中通過優化該指標能使模型產生的策略更好地接近NE。同時,本文推導了一種可實踐的,基於狀態-動作樣本的方法來優化多樣性指標。結合本文提出的多樣性指標和原始PSRO算法,可以得到一個新的PSRO變體,策略空間多樣性PSRO(PSD-PSRO)。本文在理論上分析了PSD-PSRO的收斂性質,並且通過實驗驗證PSD-PSRO更能有效地產生低可被利用性的策略。

16. 高效協同多智能體強化學習的自動分組

通過自動分組實現高效協作的多智能體強化學習

論文鏈接:https://openreview.net/pdf?id=CGj72TyGJy

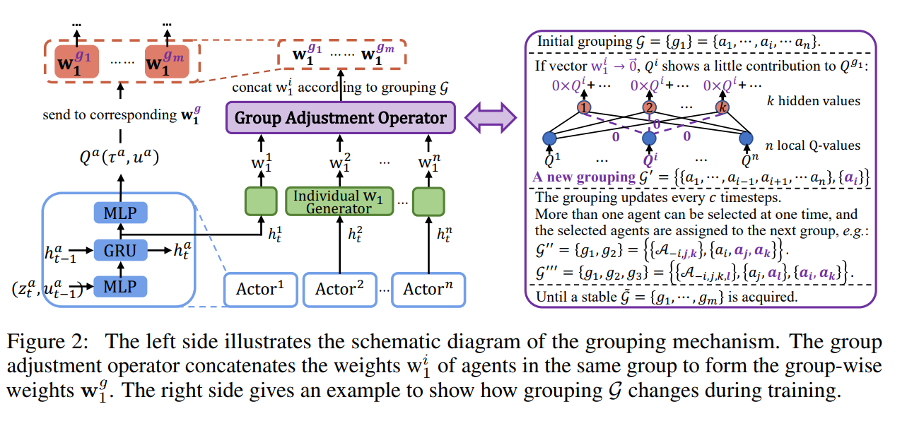

本文由騰訊AI Lab與中國科學院自動化研究所、清華大學合作完成。分組在自然系統中無處不在,其對於提升團隊協調效率至關重要。本文提出了一種新的面向羣體的多智能體強化學習,它能夠在沒有領域知識的情況下學習自動分組以實現有效的合作。與現有的直接學習聯合行動價值和個體效用之間複雜關係的方法不同,本文將分組作爲橋樑來連接各組智能體,並鼓勵他們之間的合作,從而提高整個團隊的學習效率。

具體來說,該方法將聯合行動的價值拆解爲每一組的價值,這些價值指導智能體以更細粒度的方式提升他們的策略。本文提出了一種自動分組機制來生成動態的分組以及組行動價值。進一步,本文引入了一種用於策略學習的分層控制,該控制驅動同一組中的智能體專門研究類似的策略,並在組間產生多樣化的策略。在StarCraft II微管理問題和谷歌足球場景上的實驗驗證了該方法的有效性,並且揭示了分組的工作方式以及如何提高性能。

17. 隨心所欲:用層次語義圖的運動擴散模型的細粒度控制

行動如你所願:基於層次語義圖的精細可控運動擴散模型

論文鏈接:https://arxiv.org/pdf/2311.01015.pdf

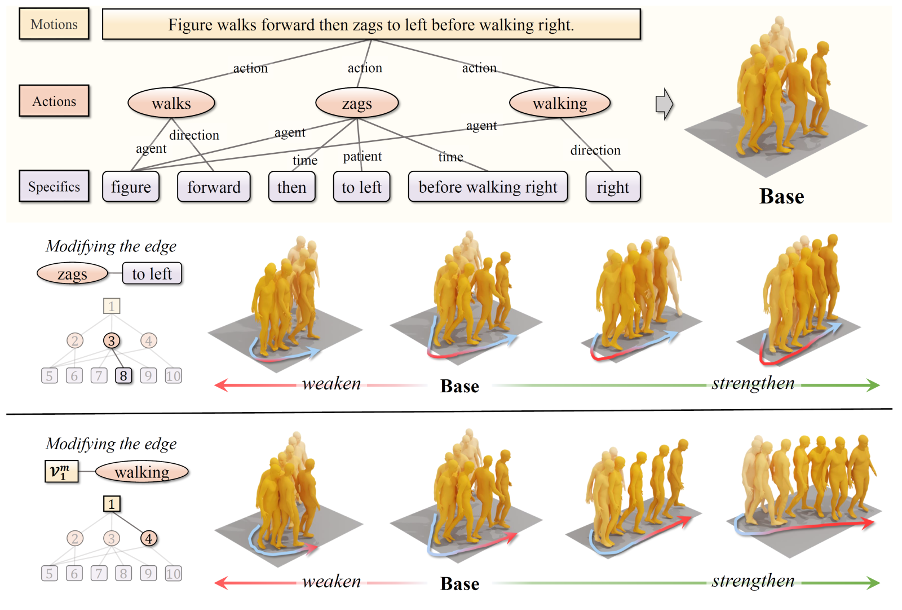

本文由騰訊AI Lab和北京大學合作完成。人體運動生成是遊戲影視製作、虛擬現實和人形機器人等領域的所必須的關鍵技術,其目標一般是生成儘可能擬真的人體運動序列。傳統的生成管線一般需要專業演員來捕捉運動,並輔以專業動畫師細緻繁雜的手工精修才能完成。近年,基於狀態機或者Motion Matching的動畫技術極大推動了人體運動的自動化生成,但仍然存在需人工收集動作片段,內存消耗大,只能做動作片段的組合,可控性有限等問題。因此,基於學習(以神經網絡爲主流)的解決方案,尤其是基於文本的人體運動生成獲得了特別的關注並剛剛取得了顯著進步。

本文提出了一種新的基於層次化語義圖的精細化可控文本生成運動方案GraphMotion。它可根據文本中所指定的運動類別,運動路徑,運動風格等信息,生成相應的3D人體骨骼序列。與現有相關方案相比,GraphMotion將輸入文本解析爲一種新的控制信號:層次語義圖,能從粗到精的從三個語義級別來分別捕獲與生成人體的整體運動、局部動作和動作細節。GraphMotion在提高結果生成質量(文本匹配準確度、運動逼真度等)的同時也保證了結果的多樣性,不僅刷新了SOTA性能,還具備通過調節語義圖(改變節點間的權重以及增減修改節點等)來實現前所未有的精細調控生成結果的額外能力。

開源鏈接:https://github.com/jpthu17/GraphMotion .

科學人工智能

18. 模擬物理動力學的等變時空關注圖網絡

模擬物理動態的等變時空注意力圖網絡

論文鏈接:

https://openreview.net/pdf?id=35nFSbEBks

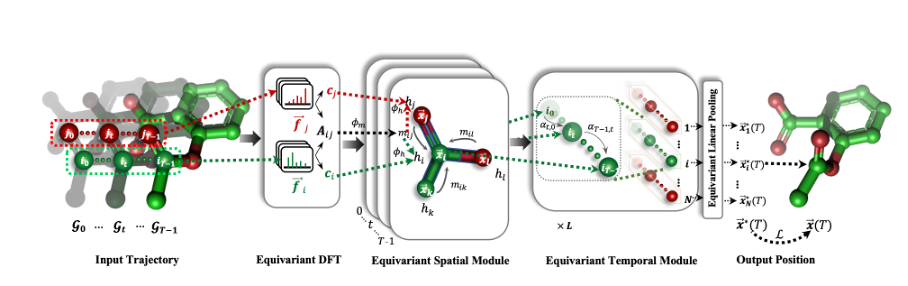

本文由騰訊AI Lab與中國人民大學合作完成。學習如何表示和模擬物理系統的動態是一項至關重要且富有挑戰性的任務。現有的等變圖神經網絡(GNN)方法已經捕捉到了物理學的對稱性,例如平移、旋轉等,從而具有更好的泛化能力。然而,這些方法在處理任務時逐幀進行,忽略了主要由環境中未觀察到的動態引起的非馬爾可夫特性。

在本文中,該方法通過利用過去一段時間的軌跡來恢復非馬爾可夫交互,將動態模擬改進爲一個時空預測任務。爲此,本文提出了一種等變時空注意力圖網絡(ESTAG),它是一種等變的時空 GNN。在其核心,本文設計了一種新穎的等變離散傅立葉變換(EDFT),用於從歷史幀中提取週期性模式,並構建了一個等變空間模塊(ESM)來完成空間信息傳遞,以及一個具有前向注意力和等變池化機制的等變時間模塊(ETM)來整合時間信息。在分別對應於分子、蛋白質和宏觀層次的三個真實數據集上的評估表明, ESTAG 與典型的時空 GNN 和等變 GNN 相比具有更高的有效性。

— 完 —

如若转载,请注明出处:https://www.tuio.cc/1130.html